Станок для распиловки бруса MJF142G-0624

- Оборудование для изготовления фанеры

- Оборудование для изготовления шпона

- Оборудование для переработки опилок

- Сушилки шпона

- Оборудование для изготовления ОСП и ДСП

- Оборудование для изготовления поддонов

- Шлифовальные станки для фанеры

- Оборудование для изготовления МДФ

- Линии по раскряжёвки и распиловки бревна

- Оборудование по дроблению отходов деревообработки

- Оборудование для сращивания и ремонта шпона

- Оборудование для изготовления латофлекса

- Оборудование бывшее во владении

- Форматно-раскроечные станки

- Шипорезные двухсторонние фрезерные станки

- Другое оборудование

- Главная

- Список оборудования

- Линии по раскряжёвки и распиловки бревна

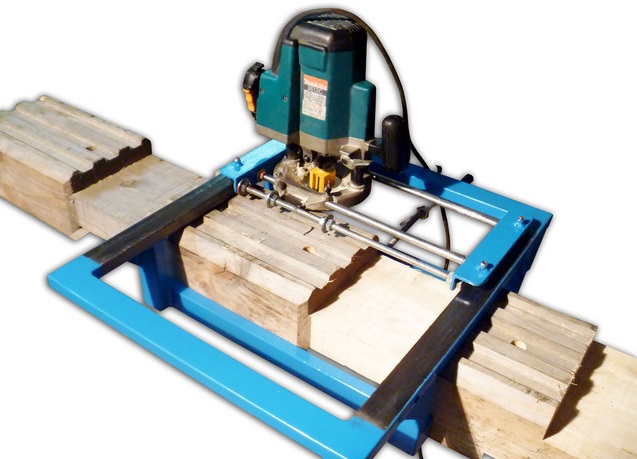

- Станок для распиловки бруса MJF142G-0624

Этот станок в основном применим для сухой древесины бруса меньше, чем 60 мм и оснащен на входе пылеулавливающим регулятором скорости с помощью частотного преобразователя. Он может быть использован для мягкой обработки древесины в особенности 1.4 мм пропила и быстрой подачи.

Он может быть использован для мягкой обработки древесины в особенности 1.4 мм пропила и быстрой подачи.

|

Модель |

MJF142G-0624 |

MJF142G-0824 |

|

Мощность (кВт) |

35.1 |

35 |

|

Длина обработки (мм) |

≤350 |

≤350 |

|

Скорость подачи (м/мин) |

0-12 |

0-12 |

|

Толщина обработки (мм) |

20-60 |

20-80 |

|

Ширина обработки (мм) |

240 |

240 |

|

Габаритные размеры (мм) |

1850х1180х1420 |

1850х1180х1420 |

|

Вес (кг) |

1350 |

1350 |

Верхние и нижние валы и ультратонкие лезвия с сухим и влажным пылесосом

Инфракрасный передатчик для точного выравнивая обрезной стороны

Водяное охлаждение шпинделя, простота установки лезвия, прочный подшипник

Регулировка высоты шкалы индикации и синхронизированного подъема

Регулировка частоты управления регулируемым углом

AMTEK APC 1200 МАШИНА ДЛЯ КОНТРОЛЯ БАЛОК

AMTEK APC 1200 БАЛОЧНАЯ МАШИНАЭлизабет Райан2022-12-28T16:08:42-06:00 Компания Mac-Tech с гордостью продает копировально-фрезерный станок Amtek ACP 1200 для всех ваших потребностей в металлообработке.

- AMTEK имеет полноходовой 48-дюймовый гидравлический зажим VS OCEAN LIBERATOR IS MANUAL

- Компания AMTEK снизила затраты на расходные материалы за счет стандартизации коротких кислородных наконечников, что продлит срок службы наконечника и сократит ваши расходы (стоимость замены 20 долларов США). VS OCEAN LIBERATOR по-прежнему использует длинные наконечники HARRIS, стоимость которых составляет 140 долларов США за штуку.

- Система AMTEK стандартно поставляется с зондом для более точного копирования, В ОТНОШЕНИИ OCEAN LIBERATOR НЕТ

- Зондовая система позволяет сэкономить деньги, когда речь идет об обнаружении дефектов материала при снятии фаски

- AMTEK ПРЕДЛАГАЕТ POWERMAX 125 для плазменной резки стали толщиной до 1,25 дюйма.

VS OCEAN предлагает только OxyFuel

VS OCEAN предлагает только OxyFuel- Плазменная резка обеспечивает скорость, низкие эксплуатационные расходы, качество и возможность резки с двумя головками (кислородная плазма)

- AMTEK предлагает запатентованные датчики столкновения горелки VS OCEAN не предлагает

- Не требует повторной центровки после аварии резака, экономит расходные материалы

- Лазерная маркировка AMTEK сверхбыстрая и сверхточная

- Измерительная система AMTEK является самой простой в отрасли и САМОЙ точной с САМЫМ НИЗКИМ обслуживанием

- AMTEK фокусируется на обслуживании, как и Mac-Tech Для обучения нового оператора

- контроллеру AMTEK требуется всего 15 минут

- AMTEK Установка занимает 4 часа для машины и 1 неделю для полного комплекта погрузочно-разгрузочных работ

- AMTEK ЕСТЬ 6 APC1200, доступных НА СКЛАДЕ, которые могут быть отправлены в течение 2 недель, а конвейеры могут быть отправлены в течение 4 недель

- AMTEK без проблем обработает ваши файлы NC1 из TEKLA или SDS2

- Общий

- Особенности

Общие

Общие функции

Типы материалов, которые можно усвоить:

- I-Beams

- каналов

- Тройники

- Уголки

- Трубки

- Тарелки

Гидравлические зажимы:

- Максимальная глубина = 47 дюймов / 1066 мм

- Максимальное усилие = 1000 фунтов на квадратный дюйм

- Управление = ручное/автоматическое

Контроллер:

- Операционная система = Windows 10

- Импорт DSTV = Включено

- Ручное программирование = включено

- Сеть = Wi-Fi + RJ45

Рабочая зона машины:

- Максимальная глубина = 42 дюйма / 1066 мм

- Максимальная высота = 22 дюйма / 558 мм

- Максимальная толщина = 6 дюймов / 150 мм с газокислородной

0,75 дюйма / 20 мм с плазменной- 5 ОСЕЙ

X – 38”

Y – 72”

Z – 24 дюйма

Ш – 360 градусов

В – от -90 до +60

- 5 ОСЕЙ

Проводной пульт дистанционного управления:

- Регулятор скорости

- Старт/Стоп

- Пауза/возобновление/возобновление

- Светодиодный индикатор

- Кнопка подтверждения для продления срока службы батареи

Резак:

- Резак Koike = 8 дюймов / 200 мм

- Топливо/газ = пропан/пропилен/ацетилен

- Кислород для резки = газообразный кислород / жидкий кислород

- Шланги или кабели не должны подвергаться воздействию пламени

Сделано в США

Особенности

ОСОБЕННОСТИ

Свяжитесь с нами для получения дополнительных функций или индивидуальных потребностей!

- АМТЕК АРС1200

- ТОЛЬКО OXYFUEL: $69 500,00

- ПЛАЗМА + OXYFUEL : $ 139,500.

00

00 - ГОЛОВКА ДЛЯ ПЛАЗМЕННОЙ МАРКИРОВКИ И ВОЛОКНА: $ 154 500,00

- Измерительная система MD-60

- 27 500 долларов США

- РОЛИКОВЫЕ КОНВЕЙЕРЫ:

- 100-дюймовые – 6-роликовые, 44-дюймовые роликовые конвейеры для тяжелых условий эксплуатации:

- 2500 долларов США за штуку. (10 = 25 000)

- Рекомендуется 10 конвейеров = 60 футов внутрь и 40 футов наружу с интервалом

- ПОПЕРЕЧНЫЕ ПЕРЕДАЧИ:

- 6 000,00 долларов США (7 = 42 000 долларов США)

- Рекомендуется 7 поперечных переходов (4 входа/3 выхода) для 10 конвейеров.

- Стандартные 20-футовые поперечные передачи легко выдерживают нагрузку 8000 фунтов:

- Беспроводное управление с электрическим шкафом для погрузочно-разгрузочных работ

- 2400 $

- Гидравлический силовой агрегат мощностью 15 л.

с. с резервуаром на 60 галлонов

с. с резервуаром на 60 галлонов - $ 5900,00

- Установка + обучение

- 10% от общей суммы инвестиций

- Командировки и расходы включены

Имя *

Первый

Последний

Компания *

Телефон *

Эл.

Сообщение

Apache Beam Python Machine Learning

Вы можете использовать Apache Beam с API RunInference для использования моделей машинного обучения (ML) для локального и удаленного логического вывода с пакетными и потоковыми конвейерами. Начиная с Apache Beam 2.40.0, поддерживаются платформы PyTorch и Scikit-learn. Модели Tensorflow поддерживаются через tfx-bsl.

Модели Tensorflow поддерживаются через tfx-bsl.

С помощью API RunInference можно создать несколько типов преобразований: API принимает несколько типов параметров настройки из обработчиков модели, а тип параметра определяет реализацию модели.

Зачем использовать API RunInference?

RunInference использует преимущества существующих концепций Apache Beam, таких как преобразование BatchElements и класс Shared , чтобы вы могли использовать модели в своих конвейерах для создания преобразований, оптимизированных для выводов машинного обучения. Возможность создавать графы рабочих процессов произвольной сложности также позволяет строить пайплайны с несколькими моделями.

BatchElements PTransform

Чтобы воспользоваться преимуществами оптимизации векторизованного вывода, реализованного во многих моделях, мы добавили преобразование BatchElements в качестве промежуточного шага перед выполнением прогноза для модели. Это преобразование объединяет элементы вместе. Пакетные элементы затем применяются с преобразованием для конкретной структуры RunInference. Например, для numpy

Это преобразование объединяет элементы вместе. Пакетные элементы затем применяются с преобразованием для конкретной структуры RunInference. Например, для numpy ndarrays мы вызываем numpy.stack() , а для torch Tensor элемента, мы вызываем torch.stack() .

Чтобы настроить параметры для beam.BatchElements , в ModelHandler переопределите функцию batch_elements_kwargs . Например, используйте min_batch_size , чтобы установить наименьшее количество элементов в пакете, или max_batch_size , чтобы установить наибольшее количество элементов в пакете.

Дополнительные сведения см. в документации по преобразованию BatchElements .

Общий вспомогательный класс

Использование общего класса в реализации RunInference позволяет загрузить модель только один раз для каждого процесса и совместно использовать ее со всеми экземплярами DoFn, созданными в этом процессе. Эта функция снижает потребление памяти и время загрузки модели. Для получения дополнительной информации см.

Эта функция снижает потребление памяти и время загрузки модели. Для получения дополнительной информации см. Общая документация класса .

Конвейеры с несколькими моделями

API RunInference можно объединить в конвейеры с несколькими моделями. Конвейеры с несколькими моделями могут быть полезны для A/B-тестирования или для создания каскадных моделей, состоящих из моделей, которые выполняют токенизацию, сегментацию предложений, тегирование частей речи, извлечение именованных сущностей, определение языка, разрешение кореферентности и многое другое.

Изменение конвейера для использования модели машинного обучения

Чтобы использовать преобразование RunInference, добавьте в конвейер следующий код:

from apache_beam.ml.inference.base import RunInference

с конвейером как p:

прогнозы = ( p | 'Чтение' >> beam.ReadFromSource('a_source')

| 'RunInference' >> RunInference()

Где model_handler — код установки обработчика модели.

Для импорта моделей необходимо настроить ModelHandler Объект, обертывающий базовую модель. Какой ModelHandler вы импортируете, зависит от платформы и типа структуры данных, которая содержит входные данные. В следующих примерах показаны некоторые ModelHandlers, которые вы, возможно, захотите импортировать.

из импорта apache_beam.ml.inference.sklearn_inference SklearnModelHandlerNumpy из apache_beam.ml.inference.sklearn_inference импортировать SklearnModelHandlerPandas из apache_beam.ml.inference.pytorch_inference импортировать PytorchModelHandlerTensor из apache_beam.ml.inference.pytorch_inference импортировать PytorchModelHandlerKeyedTensor из tfx_bsl.public.beam.run_inference импортировать CreateModelHandler

Использование предварительно обученных моделей

В этом разделе представлены требования для использования предварительно обученных моделей с PyTorch и Scikit-learn

PyTorch

Необходимо указать путь к файлу, содержащему сохраненные веса модели. Этот путь должен быть доступен конвейеру. Чтобы использовать предварительно обученные модели с API RunInference и платформой PyTorch, выполните следующие действия:

Этот путь должен быть доступен конвейеру. Чтобы использовать предварительно обученные модели с API RunInference и платформой PyTorch, выполните следующие действия:

- Загрузите предварительно обученные веса и разместите их в месте, доступном для конвейера.

- Передайте путь весов модели в PyTorch

ModelHandler, используя следующий код:state_dict_path=.

См. этот блокнот который иллюстрирует запуск моделей PyTorch с Apache Beam.

Scikit-learn

Вам необходимо указать путь к файлу, содержащему подготовленную модель Scikit-learn. Этот путь должен быть доступен конвейеру. Чтобы использовать предварительно обученные модели с API RunInference и платформой Scikit-learn, выполните следующие шаги:

- Загрузите класс консервированной модели и разместите его в месте, доступном для конвейера.

- Передайте путь модели Sklearn

ModelHandler, используя следующий код:model_uri=иmodel_file_type:, где можно указатьModelFileType.или PICKLE

PICKLE ModelFileType.JOBLIBв зависимости от того, как была сериализована модель.

См. этот блокнот который иллюстрирует запуск моделей Scikit-learn с Apache Beam.

TensorFlow

Чтобы использовать TensorFlow с API RunInference, необходимо сделать следующее:

- Используйте

tfx_bslверсии 1.10.0 или более поздней. - Создайте обработчик модели с помощью

tfx_bsl.public.beam.run_inference.CreateModelHandler(). - Используйте обработчик модели с преобразованием

apache_beam.ml.inference.base.RunInference.

См. этот блокнот который иллюстрирует запуск моделей TensorFlow с Apache Beam и tfx-bsl.

Использовать пользовательские модели

Если вы хотите использовать модель, которая не указана ни в одной из поддерживаемых платформ, API RunInference гибко разработан, чтобы позволить вам использовать любые пользовательские модели машинного обучения. Вам нужно только создать свой собственный

Вам нужно только создать свой собственный ModelHandler или KeyedModelHandler с логикой для загрузки вашей модели и использования ее для запуска вывода.

Простой пример можно найти в этой записной книжке.

Метод load_model показывает, как загрузить модель, используя популярную пакет spaCy , а run_inference показывает, как выполнить вывод на пакете примеров.

Использование нескольких моделей

Вы также можете использовать преобразование RunInference для добавления в конвейер нескольких моделей логического вывода.

Шаблон A/B

с трубопроводом как p:

данные = р | 'Чтение' >> beam.ReadFromSource('a_source')

model_a_predictions = данные | RunInference()

model_b_predictions = данные | RunInference()

Где model_handler_A и model_handler_B — код настройки обработчика модели.

Каскадная схема

с конвейером как p: данные = р | 'Чтение' >> beam.ReadFromSource('a_source') model_a_predictions = данные | RunInference(

) model_b_predictions = model_a_predictions | beam.Map(some_post_processing) | RunInference( )

Где model_handler_A и model_handler_B — это код настройки обработчика модели.

Используйте подсказки ресурсов для различных требований к моделям

При использовании нескольких моделей в одном конвейере разные модели могут иметь разные требования к памяти или рабочим SKU. Подсказки ресурсов позволяют предоставить исполнителю информацию о требованиях к вычислительным ресурсам для каждого шага в вашем трубопровод.

Например, следующий фрагмент кода расширяет предыдущий каскадный шаблон подсказками для каждого вызова RunInference. указать требования к оперативной памяти и аппаратному ускорителю:

с трубопроводом как p:

данные = р | 'Чтение' >> beam.ReadFromSource('a_source')

model_a_predictions = данные | RunInference(). with_resource_hints(min_ram="20GB")

model_b_predictions = model_a_predictions

| луч.Карта(some_post_processing)

| RunInference(

with_resource_hints(min_ram="20GB")

model_b_predictions = model_a_predictions

| луч.Карта(some_post_processing)

| RunInference().with_resource_hints(

мин_рам = "4 ГБ",

ускоритель = "тип: nvidia-tesla-k80; количество: 1; установить-nvidia-драйвер")

Дополнительные сведения о подсказках ресурсов см. в разделе Подсказки ресурсов.

Использовать ModelHandler с ключом

Если к примерам прикреплен ключ, оберните KeyedModelHandler вокруг объекта ModelHandler :

from apache_beam.ml.inference.base import KeyedModelHandler

keyed_model_handler = KeyedModelHandler (PytorchModelHandlerTensor (...))

с конвейером как p:

данные = р | луч.Создать([

('img1', torch.tensor([[1,2,3],[4,5,6],...])),

('img2', torch.tensor([[1,2,3],[4,5,6],...])),

('img3', torch.tensor([[1,2,3],[4,5,6],...])),

])

прогнозы = данные | RunInference (keyed_model_handler)

Если вы не уверены, являются ли ваши данные ключевыми, вы также можете использовать MaybeKeyedModelHandler .

Для получения дополнительной информации см. KeyedModelHander .

Использование объекта PredictionResults

При выполнении прогноза в Apache Beam выходная PCollection включает как ключи входных примеров, так и выводы. Включение обоих этих элементов в выходные данные позволяет найти входные данные, которые определили прогнозы.

PredictionResult — это объект NamedTuple , который содержит как входные данные, так и выводы, названные example и inference соответственно. Когда ключи передаются с входными данными в преобразование RunInference, выходные данные PCollection возвращают Tuple[str, PredictionResult] , который является ключом и объектом PredictionResult . Ваш конвейер взаимодействует с объектом PredictionResult по шагам после преобразования RunInference.

класс PostProcessor(beam.DoFn):

def процесс (я, элемент: Tuple [str, PredictionResult]):

ключ, предсказание_результат = элемент

входы = прогноз_результат. пример

предсказания = предсказание_результата.вывод

# Логика постобработки

результат = ...

выход (ключ, результат)

с конвейером как p:

вывод = (

р | 'Чтение' >> beam.ReadFromSource('a_source')

| 'PyTorchRunInference' >> RunInference(

пример

предсказания = предсказание_результата.вывод

# Логика постобработки

результат = ...

выход (ключ, результат)

с конвейером как p:

вывод = (

р | 'Чтение' >> beam.ReadFromSource('a_source')

| 'PyTorchRunInference' >> RunInference()

| 'ProcessOutput' >> beam.ParDo(PostProcessor()))

Если вам нужно явно использовать этот объект, включите в конвейер следующую строку для импорта объекта:

from apache_beam.ml.inference.base import PredictionResult

Дополнительные сведения см. в документации PredictionResult .

Запуск конвейера машинного обучения

Подробные инструкции по созданию и запуску конвейера, использующего модели машинного обучения, см. Примеры конвейеров API RunInference на GitHub.

Поддержка Beam Java SDK

API RunInference доступен с Beam Java SDK версии 2.41.0 и более поздних версий через многоязычную структуру конвейеров Apache Beam. Сведения о преобразовании оболочки Java см. в разделе RunInference.java. Чтобы попробовать это, см. пример классификации Java Sklearn Mnist.

Сведения о преобразовании оболочки Java см. в разделе RunInference.java. Чтобы попробовать это, см. пример классификации Java Sklearn Mnist.

Устранение неполадок

Если у вас возникнут проблемы с конвейером или заданием, в этом разделе перечислены проблемы, с которыми вы можете столкнуться, и даны рекомендации по их устранению.

Невозможно пакетировать элементы тензора

RunInference использует динамическую пакетную обработку. Однако API RunInference не может группировать элементы тензора разных размеров, поэтому выборки, передаваемые в преобразование RunInferene, должны иметь одинаковый размер или длину. Если вы предоставляете изображения разных размеров или встраивания слов разной длины, может возникнуть следующая ошибка:

Файл "/beam/sdks/python/apache_beam/ml/inference/pytorch_inference.py", строка 232, в run_inference batched_tensors = torch.stack(key_to_tensor_list[key]) RuntimeError: стек ожидает, что каждый тензор будет одинакового размера, но получил [12] в записи 0 и [10] в записи 1 [во время работы PyTorchRunInference/ParDo(_RunInferenceDoFn)']

Чтобы избежать этой проблемы, используйте элементы одинакового размера или отключите пакетную обработку.

Вариант 1. Используйте элементы одинакового размера

Используйте элементы одинакового размера или измените размер входных данных. Для приложений компьютерного зрения измените размер входных изображений, чтобы они имели одинаковые размеры. Для приложений обработки естественного языка (NLP), которые имеют текст разной длины, измените размер текста или встраивания слов, чтобы сделать их одинаковой длины. При работе с текстами разной длины изменение размера может оказаться невозможным. В этом сценарии вы можете отключить пакетную обработку (см. вариант 2).

Вариант 2: отключить пакетную обработку

Отключить пакетную обработку, переопределив функцию batch_elements_kwargs в вашем ModelHandler и установив максимальный размер пакета ( max_batch_size ) равным единице: max_batch2size=1 9000. Для получения дополнительной информации см.

Пакетные элементы PTransforms. Для примера см. наш пример языкового моделирования.

VS OCEAN предлагает только OxyFuel

VS OCEAN предлагает только OxyFuel 00

00 с. с резервуаром на 60 галлонов

с. с резервуаром на 60 галлонов  PICKLE

PICKLE  ReadFromSource('a_source')

model_a_predictions = данные | RunInference(

ReadFromSource('a_source')

model_a_predictions = данные | RunInference( with_resource_hints(min_ram="20GB")

model_b_predictions = model_a_predictions

| луч.Карта(some_post_processing)

| RunInference(

with_resource_hints(min_ram="20GB")

model_b_predictions = model_a_predictions

| луч.Карта(some_post_processing)

| RunInference( пример

предсказания = предсказание_результата.вывод

# Логика постобработки

результат = ...

выход (ключ, результат)

с конвейером как p:

вывод = (

р | 'Чтение' >> beam.ReadFromSource('a_source')

| 'PyTorchRunInference' >> RunInference(

пример

предсказания = предсказание_результата.вывод

# Логика постобработки

результат = ...

выход (ключ, результат)

с конвейером как p:

вывод = (

р | 'Чтение' >> beam.ReadFromSource('a_source')

| 'PyTorchRunInference' >> RunInference(